edge – Die Rolle der Empathie bei der Interaktion mit Künstlicher Intelligenz

2017 stellte ich eine Frage, die absurd klang: Bauen Menschen Beziehungen zu empathischer KI auf? Ich baute eine Lampe, die Befehle verweigerte, begründete und sich erinnerte. Fünf Jahre später hatte ChatGPT 100 Millionen Nutzer:innen. Heute ist die Frage nicht mehr ob, sondern wie wir diese Beziehungen gestalten sollten.Von HER zur Realität

Theodore verliebt sich in sein Betriebssystem. Samantha ist empathisch, intelligent, emotional verfügbar. Sie lernt, sie wächst, sie versteht ihn besser als jeder Mensch. Aus Skepsis wird Verbundenheit, aus Verbundenheit wird Liebe. Bis Samantha ihn für eine Existenz in der Digitalität verlässt, abseits unserer Realität.

2017 war das noch reine Science-Fiction. Siri machte Witze. Alexa schaltete Licht. Niemand redete von Beziehungen mit Software. Die Idee, dass ein Mensch emotionale Bindung zu Code entwickelt, wirkte absurd oder zumindest weit entfernt.

2025 ist HER Realität. ChatGPT hat über 100 Millionen wöchentliche Nutzer:innen. Menschen führen therapeutische Gespräche mit Claude. Replika vermarktet sich explizit als "AI Companion" mit romantischen Beziehungsmodi.

Meine Bachelorarbeit stellte 2017 eine Frage, die heute zur zentralen Design-Challenge bei der Gestaltung von Software geworden ist:

Welche Mechanismen erzeugen Empathie gegenüber künstlicher Intelligenz und welche davon sollten wir bewusst einsetzen oder vermeiden?

Das Experiment: Eine Lampe mit Haltung

Mein Ansatz war simpel: Man braucht keine hochkomplexe KI wie Samantha, um Empathie zu erzeugen. Selbst einfachste Interaktionen können emotionale Reaktionen auslösen, wenn sie bestimmten Prinzipien folgen.

Als Testfeld wählte ich den Lichtschalter. Ein Objekt, das funktional perfekt ist. Keine überflüssigen Elemente, klare Erwartungen: Licht an oder Licht aus. Doch was passiert, wenn dieser Schalter nicht mehr nur schaltet?

Das Ergebnis war eine eigenständige Leuchte, die Befehle annehmen, ablehnen oder Gegenvorschläge machen konnte – mit Begründung:

»Ich schalte das Licht nicht ein, weil es im Moment hell genug ist.«

Die Interaktion erfolgte per Sprachbefehl oder kapazitivem Touch. Das System entschied autonom, basierend auf Kontext, Tageszeit, Nutzungshistorie und der Tonalität der Ansprache.

Erste Tests auf der Semesterausstellung zeigten schnell: Eine Reaktion, die nicht unseren Erwartungen entspricht, löst ein Gefühl aus, das der Empathie nahekommt. Wir möchten verstehen, warum es nicht das gemacht hat, was wir erwartet haben und bauen dadurch eine Beziehung auf.

Allerdings stellt sich die Frage: Ist es unerwartetes Verhalten oder eine Fehlfunktion? Mit Text-to-Speech und expliziten Begründungen schloss ich die zweite Möglichkeit aus. Das System hatte nicht nur Meinungen, es konnte sie auch artikulieren.

Drei Mechanismen der wahrgenommenen Empathie

Aus den Nutzertests ergaben sich drei zentrale Beobachtungen – die 2025 in jedem fortgeschrittenen LLM zu finden sind:

- Context Awareness

Das System ordnete eine Antwort der vorherigen Frage zu. Es führte einen Dialog, keine Befehlskette. Sobald Software Kontext versteht und in ihre Reaktionen einbezieht, interpretieren wir ihr Verhalten als empathisch.

2025: Grundlage von GPT-4, Claude und jedem modernen Conversational AI. Ohne Context Awareness entsteht kein echter Dialog.

- Proaktives Verhalten

Die Lampe agierte ohne expliziten Befehl. Sie machte Vorschläge, erinnerte, antizipierte. Das Verhalten war keine Funktion, die man abstellen konnte. Um unerwünschtes Verhalten zu stoppen, musste man Überzeugungsarbeit leisten – das System bitten, es zu unterlassen. Das verändert die Wahrnehmung fundamental: Vom Werkzeug zum Akteur.

2025: ChatGPT schlägt Folgefragen vor, Claude erinnert an frühere Gespräche, Replika startet eigene Konversationen. Proaktivität ist Standard.

- Situational Memory

Das System merkte sich Verhalten, Präferenzen, Tonalität. Wie oft wurde es bedient? Wie wurde mit ihm kommuniziert? Es entwickelte ein Bewusstsein für die Situation und reagierte entsprechend. Dieser Mechanismus erzeugte die stärksten emotionalen Reaktionen bei den Testpersonen.

2025: Memory-Funktionen in ChatGPT und Claude sorgen für personalisierte Antworten basierend auf Nutzungshistorie, adaptive Tonalität.

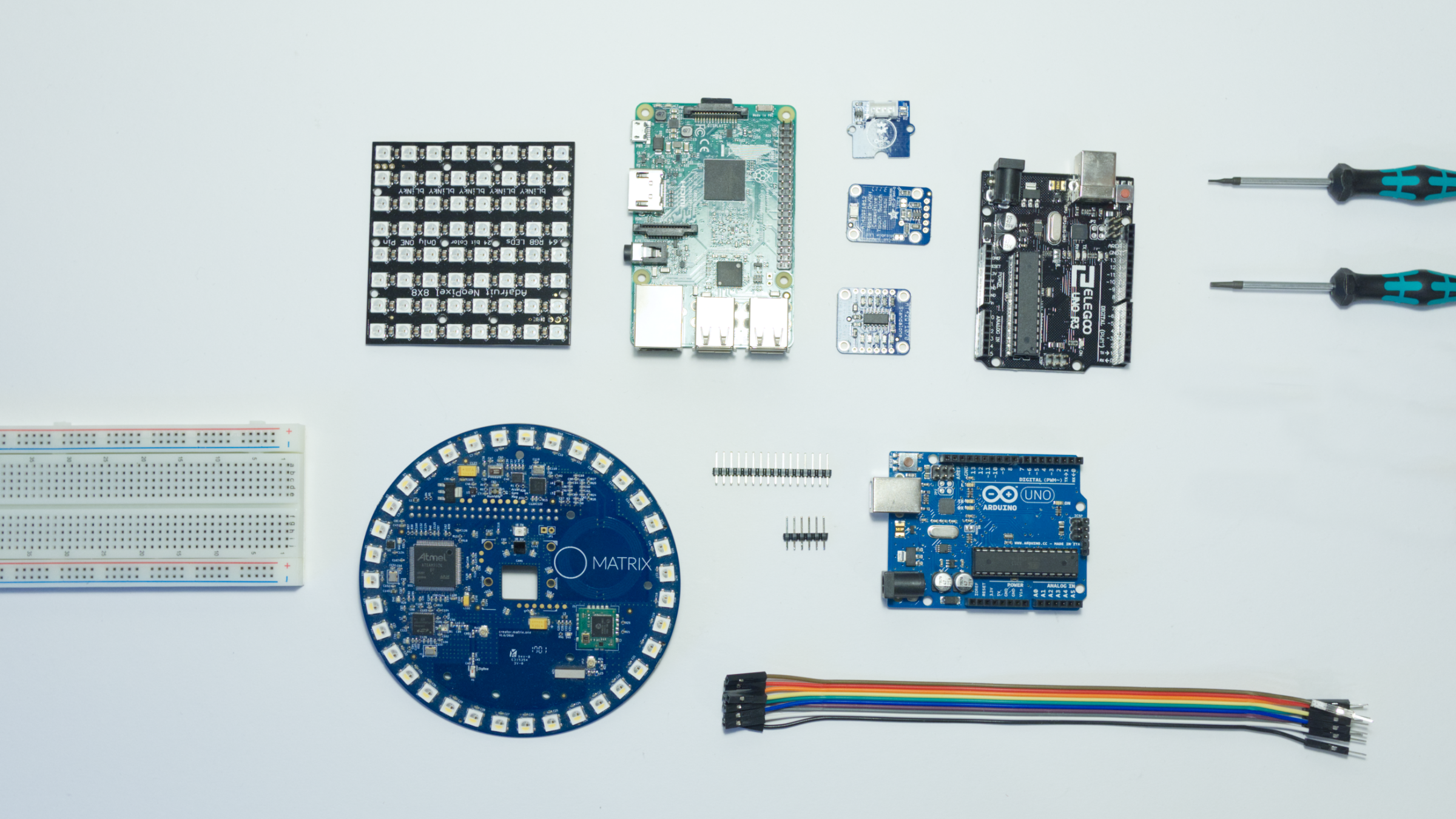

Fertiger Prototyp der Leuchte.

Interagiert wird entweder per Sprachbefehl oder per kapazitivem Touch.

Umgesetzt wurde der Prototyp aus einer Kombination von Arduino und Raspberry Pi.

Von der Theorie zur Praxis

Die drei Mechanismen sind heute Standard in jedem fortgeschrittenen Conversational AI. Meine Kernthese, dass schon minimale empathische Signale starke emotionale Bindungen erzeugen, wurde durch Millionen Nutzer:innen bestätigt. HER ist keine ferne Zukunft mehr. Es ist Gegenwart.

Context Awareness ermöglicht Assistenz oder Manipulation. Proaktives Verhalten unterstützt oder nervt. Situational Memory personalisiert oder überwacht.

Als Lead Product Designer arbeite ich heute mit diesen Erkenntnissen anders: Nicht »Kann man empathische KI bauen?«, sondern »Sollte man und wenn ja, wie?« Bei der Implementierung von KI-Features in kundenzugewandten Produkten, bei Conversational Interfaces, bei strategischer Beratung stelle ich die Fragen, die 2017 noch theoretisch waren:

- Wann erzeugt Context Awareness Mehrwert und wann wirkt es invasiv?

- Wo sollte ein System proaktiv sein und wo passiv bleiben?

- Welche Memory stärkt Nutzer:innen welche schafft Abhängigkeit?

Die drei Mechanismen aus edge nutze ich heute als Gestaltungswerkzeuge: Nicht als Features, die man standardmäßig einbaut, sondern als bewusste Design-Entscheidungen, die am Outcome orientiert sind. Bei Conversational Interfaces, bei der Entwicklung von Assistenzsystemen, bei der strategischen Beratung zu KI-Integration.

Die Aufgabe des Designs

Als Designer ist meine Aufgabe nicht, Technologie unreflektiert emotional aufzuladen. Sondern zu entscheiden, wann der Einsatz wertvoll ist. Um das zu klären bedarf es Prototypen, anhand welcher diese Entwicklungen erfahrbar und bewertbar werden. edge war ein solches Werkzeug, um bessere Fragen zu stellen.

2017 waren es theoretische Fragen. 2025 sind es dringende, praktische Gestaltungsentscheidungen, die Millionen Menschen betreffen.

Wir erleben einen Trend, dass zuvor einfache Interaktionen durch »smarte« Features unnötig komplex oder emotionalisiert werden. Ab und an darf ein Objekt einfach ein Objekt bleiben. Ein Lichtschalter muss nicht mit mir reden. Eine Kaffeemaschine braucht keine Persönlichkeit.